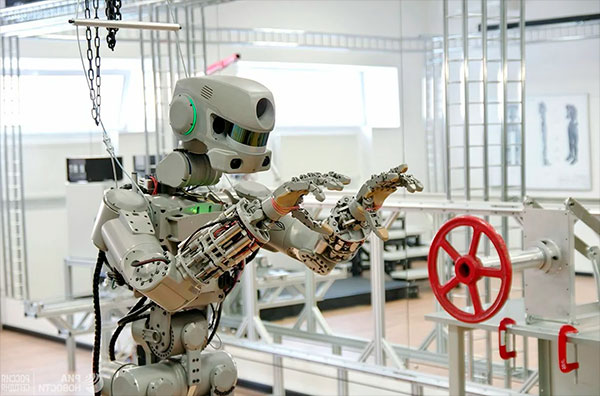

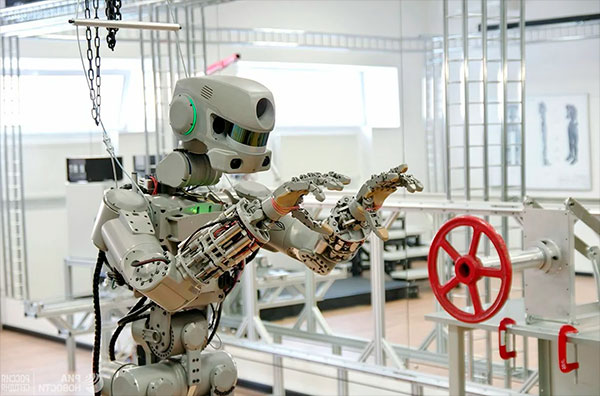

В массовой культуре искусственный интеллект (ИИ) с давних пор вызывает противоречивые чувства. Основное из которых – страх. Этому способствует и то, что многие известные ученые и инженеры, такие как Стивен Хокинг и Илон Маск предупреждали и предупреждают о неизбежном столкновении человечества с враждебным искусственным разумом.

Известной ученый, профессор Калифорнийского университета (город Беркли, США) Рассел Стюарт также приходит к выводу о том, что людям в недалеком будущем предстоит решать возможные проблемы с искусственными интеллектами. Однако в его предположениях это не злые роботы, которые восстали против власти человека. Согласно представлениям ученого машины достигнут такой степени эффективности, что станут уничтожать человечество, при этом выполняя задачи, которые люди же перед ними и поставили.

Стюарт Рассел (родился в 1962 году в г. Портсмуте, Англия) является известным экспертом в области машинного обучения. Среди его печатных трудов есть книга о совместимости человека с ИИ и контроля над последним («"Human Compatible: AI and the Problem of Control").

В ней он приходит к выводу о том, что современные представления о робоапокалипсисе, которые в различных интерпретациях реализует на экранах Голливуд, неверные по сути. Роботы с искусственным интеллектом не могут испытывать эмоций и делать выводы о ненависти к человеческой расе. И на этой основе приходить к заключению о необходимости уничтожения людей. По мнению Рассела, следует обращать внимание не на сознание роботоподобых агрегатов с ИИ, а на их компетентность при выполнении задач, поставленных людьми.

Высокая степень компетенции искусственного интеллекта

Некоторое время назад Стивен Рассел подробно описал гипотетическую ситуацию, при которой искусственный интеллект будет реально угрожать человечеству. Он посоветовал представить, что создан очень мощный искусственный интеллект, задача которого обеспечить контроль за климатическими изменениями на Земле. При этом основная цель - возвращение уровня углекислого газа в атмосфере к показателям, которые существовали на планете до начала индустриального периода.

Рассел полагает, с большой степенью вероятности, что ИИ придет к выводу о том, что для достижения нужного результата самым эффективным способом нужно будет уничтожить человеческий род. Так как он без сомнения придет к выводу о том, что именно люди производят основную массу углекислого газа.

Для того чтобы обойти такое негативное отношение ИИ к человечеству можно поставить условие о недопустимости уничтожения людей. Однако система встанет перед выбором, что же ей тогда делать. Она, по всей видимости, придёт к тому, что примет меры, приводящие к уменьшению (прекращению) рождаемости. И её действия приведут к исчезновению людей совсем, но через определенный промежуток времени.

Стивен Рассел данным примером показал, что не обдуманные инструкции данные искусственному интеллекту со стороны человека могут привести к самым негативным последствиям.

Искусственный сверхинтеллект

Системы ИИ созданные в настоящее время используются исключительно в конкретных, узкоспециализированных областях. При этом проблемы, стоящие перед ними, чётко обозначены и создаются они исключительно для их решения. К таких обобщенным выводам пришли ученые специального центра изучения экзистенциальных рисков в Кембриджском университете.

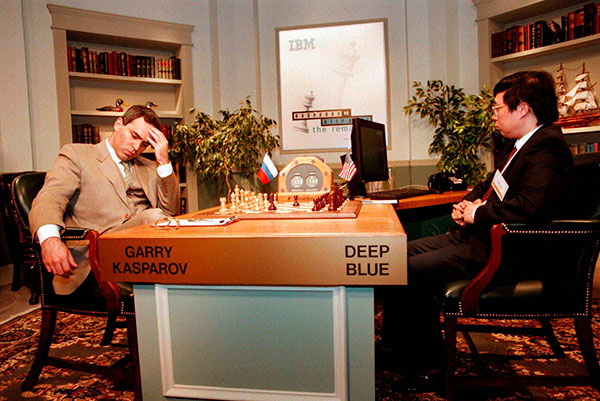

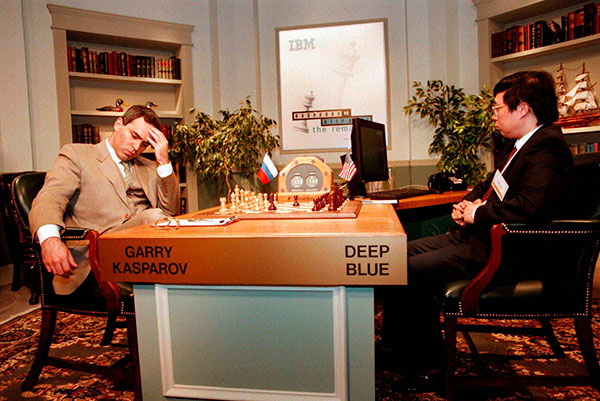

В качестве подтверждения отстаиваемой ими теории приводится впечатляющий результат специализированного компьютера «Дип Блю» (Deep Blue — шахматный сверхмощный компьютер, созданный в 1997г.). В год своего создания он выиграл матч из 6-ти партий у действующего чемпиона мира по шахматам Г. Каспарова. Однако стоит заметить, что на другие игры он не был ориентирован и в простых состязаниях по шашкам «Дип Блю» оказался бы на самом последнем месте.

Более впечатляющими выглядят достижения программы AlphaGo Zero, выдающегося представителя ИИ. Примечательно, что в процессе самостоятельного обучения какими-либо данными о прошлых играх людей в Go система не интересовалась. Но за 3 дня учебы смогла выйти на чрезвычайно высокий уровень, который обычный человек достичь не может.

Создатели AlphaGo Zero использовали при создании программы так называемые алгоритмы глубинного обучения. Применяемые ими методы означали то, что они принимали сравнительно небольшое участие в ее учебе. Программа обучалась практически самостоятельно. Более того, AlphaGo Zero научилась играть на приличном уровне в сёги (японская настольная логическая игра шахматного типа) и шахматы.

Подобные достижения ИИ действительно могут вызвать определенные опасения. Эксперты центра изучения экзистенциальных рисков подчеркивают, что в процессе развития программ искусственного интеллекта они становятся универсальными и мощными. Вследствие этого появляются риски обретения ими сверхразумных качеств. Данное обстоятельство, рано или поздно, приведет к возникновению многократного превосходства ИИ во многих областях по сравнению со своими создателями.

Профессор Рассел в своих трудах и публичных выступлениях отмечает, что ставить перед искусственным интеллектом узкие, конкретные задания не является выходом из положения и решением вопроса по устранению возможных угроз со стороны ИИ человечеству. Практика показывает, что люди не могут правильно сформулировать цели и задачи перед машинным разумом. Ученый подчеркивает - человек не способен понять, что ему не нравится пока этого не происходит.

Рассел считает правильным изменить сам подход к созданию систем искусственного интеллекта. Он полагает, что действия, при котором роботам даются задания для достижения конкретной цели, в корне неверны. Системы ИИ должны понимать, что цели ей непонятны, и в процессе своей деятельности они полностью зависят от людей. Они должны спрашивать разрешения на какие-либо действия, вследствие того, что у них возникает неуверенность в том - хочет ли этого человек либо нет.

Профессор в своих рассуждениях подчёркивает главную мысль – системы искусственного интеллекта не должны сопротивляться решению человека на их выключение. В основу их создания надо закладывать постулат о том, что они не имеют права делать то, что создателю не нравится.

Джин из лампы Алладина

Но в настоящее время искусственные интеллекты, по мнению Стивена Рассела, создаются таким образом, что они напоминают сказочных джинов из бутылки. Следуя логике такого аллегорического подхода получается, что человек трет лампу и говорит ИИ - надо то-то и то-то. И если искусственный интеллект обладает соответствующими мощностями и возможностями, то он сделает именно то, о чем его просят. Однако большинство историй с джинами заканчиваются тем, что третьим желанием становиться задача по отмене двух первых, так как изначально они были сформулированные неверно. Из этого следует - искусственный интеллект, робот, который решает задачи неверной цели, т.е. де-факто становится врагом людей и при этом гораздо сильнее их.

комментариев 1

(посмотреть последние комментарии)

Роботоапокалипсис

Роботоапокалипсис В массовой культуре искусственный интеллект (ИИ) с давних пор вызывает противоречивые чувства. Основное из которых – страх. Этому способствует и то, что многие известные ученые и инженеры, такие как Стивен Хокинг и Илон Маск предупреждали и предупреждают о неизбежном столкновении человечества с враждебным искусственным разумом.

В массовой культуре искусственный интеллект (ИИ) с давних пор вызывает противоречивые чувства. Основное из которых – страх. Этому способствует и то, что многие известные ученые и инженеры, такие как Стивен Хокинг и Илон Маск предупреждали и предупреждают о неизбежном столкновении человечества с враждебным искусственным разумом.